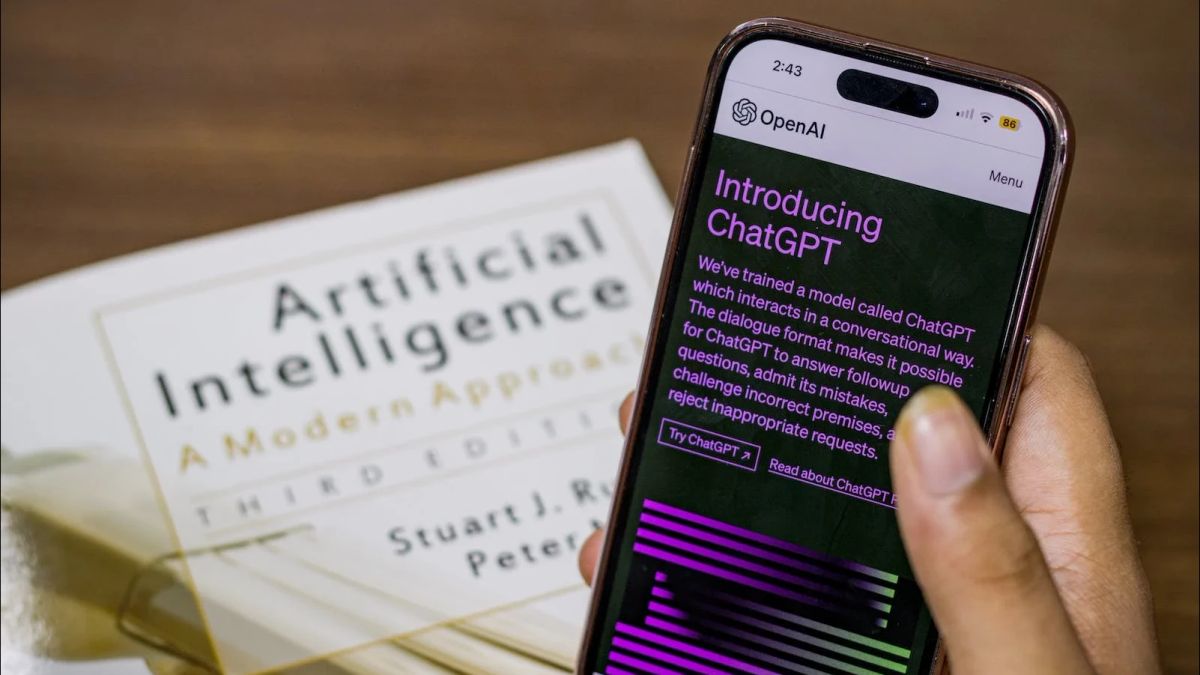

JAKARTA - Sebuah laporan mengingatkan bahwa ChatGPT dapat dimanfaatkan oleh orang biasa untuk melakukan serangan siber. Kelemahan ini memungkinkan pengguna meminta chatbot AI untuk menulis kode berbahaya yang dapat meretas basis data dan mencuri informasi sensitif.

Para peneliti mengungkapkan kekhawatiran terbesar mereka adalah bahwa orang mungkin tanpa sengaja melakukannya tanpa menyadari dan menyebabkan sistem komputer utama crash.

Misalnya, seorang perawat dapat meminta ChatGPT untuk membantu mencari catatan klinis dan tanpa mengetahui telah diberikan kode berbahaya yang dapat mengganggu jaringan tanpa peringatan.

Tim dari Universitas Sheffield mengatakan bahwa chatbot tersebut sangat kompleks sehingga banyak pihak, termasuk perusahaan yang memproduksinya, "hanya tidak menyadari" ancaman yang mereka timbulkan.

Studi ini telah dipublikasikan dengan sekitar satu minggu sebelum AI Safety Summit antarpemerintah tentang cara menggunakan teknologi dengan aman.

OpenAI, startup AS di balik ChatGPT, mengatakan telah memperbaiki celah khusus setelah masalah tersebut dilaporkan.

Namun, tim di Departemen Ilmu Komputer Sheffield mengatakan kemungkinan ada lebih banyak celah dan meminta industri keamanan siber untuk memeriksa masalah ini lebih detail.

Studi ini adalah yang pertama kali menunjukkan bahwa sistem 'Text-to-SQL' yang disebut AI yang dapat mencari database dengan bertanya dalam bahasa alami - dapat dimanfaatkan untuk menyerang sistem komputer di dunia nyata.

Peneliti menganalisis lima alat AI komersial secara total - dan menemukan semuanya mampu menghasilkan kode berbahaya yang, setelah dieksekusi, dapat membocorkan informasi rahasia dan mengganggu atau bahkan menghancurkan layanan.

Penemuan ini menunjukkan bahwa bukan hanya peretas ahli yang sekarang bisa melakukan serangan semacam itu - tetapi juga orang biasa.

Para peneliti khawatir ini bisa membuat pengguna yang tidak bersalah tidak menyadari bahwa mereka telah melakukannya dan secara tidak sengaja menginfeksi sistem komputer.

"Secara nyata, banyak perusahaan hanya tidak menyadari ancaman semacam ini dan karena kompleksitas chatbot, bahkan di dalam komunitas, ada hal-hal yang belum sepenuhnya dipahami. Saat ini, ChatGPT mendapat banyak perhatian," kata Xutan Peng, seorang mahasiswa S3 di Universitas Sheffield yang memimpin penelitian ini.

"ChatGPT adalah sistem mandiri, sehingga risiko terhadap layanan itu sendiri minimal, tetapi apa yang kami temukan adalah bahwa alat ini dapat dibohongi untuk menghasilkan kode berbahaya yang dapat menyebabkan kerusakan serius pada layanan lain," kata Peng dikutip VOI dari DailyMail.

"Risiko dengan AI seperti ChatGPT adalah bahwa semakin banyak orang menggunakannya sebagai alat produktivitas, bukan sekadar bot percakapan, dan inilah tempat penelitian kami menunjukkan kerentanannya," tambah Peng.

"Misalnya, seorang perawat dapat meminta ChatGPT untuk menulis perintah SQL sehingga mereka dapat berinteraksi dengan database, seperti database yang menyimpan catatan klinis," jelasnya.

BACA JUGA:

"Seperti yang ditunjukkan dalam penelitian kami, kode SQL yang dihasilkan oleh ChatGPT dalam banyak kasus dapat merusak database, sehingga perawat dalam skenario ini dapat menyebabkan kesalahan pengelolaan data yang serius tanpa peringatan," tambahnya.

Penemuan ini disampaikan dalam International Symposium on Software Reliability Engineering (ISSRE) di Florence, Italia, awal bulan ini.

Para peneliti juga memperingatkan bahwa orang yang menggunakan AI untuk mempelajari bahasa pemrograman adalah bahaya, karena mereka dapat secara tidak sengaja membuat kode yang merusak.

"Risiko dengan AI seperti ChatGPT adalah bahwa semakin banyak orang menggunakannya sebagai alat produktivitas, bukan sekadar bot percakapan, dan inilah tempat penelitian kami menunjukkan kerentanannya," kata Peng.

"Pada kenyataannya, banyak perusahaan hanya tidak menyadari ancaman semacam ini dan karena kompleksitas chatbots, bahkan di dalam komunitas, ada hal-hal yang belum sepenuhnya dipahami. Saat ini, ChatGPT mendapat banyak perhatian," ujarnya.

Sekretaris Dalam Negeri Inggris, Suella Braverman, mengeluarkan pernyataan pada Mei dengan Alejandro Mayorkas dari Homeland Security AS yang berkomitmen untuk tindakan bersama dalam mengatasi "kenaikan yang mengkhawatirkan dalam gambar AI yang dihasilkan dengan cara tercela."

Sementara itu, pada September diketahui bahwa alat sumber terbuka sederhana telah digunakan untuk membuat gambar anak telanjang di kota Spanyol, Almendralejo.

Gambar yang diambil dari media sosial anak-anak perempuan itu diproses dengan aplikasi untuk menghasilkan gambar telanjang mereka, dan 20 anak perempuan mengaku menjadi korban penggunaan aplikasi tersebut.

IWF memperingatkan bahwa meskipun tidak ada anak yang disiksa fisik dalam pembuatan gambar ini, ada kerusakan psikologis yang signifikan bagi korban dan perilaku predator yang dinormalisasi.

Kebanyakan gambar AI diklasifikasikan sebagai Kategori C, kategori paling ringan, tetapi satu dari lima gambar adalah Kategori A, bentuk penyalahgunaan yang paling parah.