JAKARTA - Apple baru saja mendapatkan surat terbuka yang mengecam perusahaan untuk membatalkan pemindaian foto-foto pengguna Mac, iPad, dan iPhone sebagai bukti pelecehan anak.

Surat itu telah ditandatangani oleh pendukung privasi, pakar keamanan, perusahaan teknologi, dan spesialis hukum. Dalam surat tersebut, mereka menyebutkan langkah Apple saat ini mengancam untuk melemahkan pekerjaan puluhan tahun yang dihasilkan para teknolog, akademisi, dan pendukung kebijakan menuju langkah-langkah pelestarian privasi yang kuat menjadi norma di sebagian besar perangkat elektronik konsumen dan kasus penggunaan.

"Kami meminta Apple mempertimbangkan kembali peluncuran teknologinya, agar tidak membatalkan pekerjaan penting itu," ungkap surat tersebut seperi dikutip dari Beta News, Senin 9 Agustus.

Para penandatangan mengajukan dua permintaan, yang mana penerapan teknologi pemantauan konten yang diusulkan Apple segera dihentikan. Apple harus mengeluarkan pernyataan yang menegaskan kembali komitmen mereka terhadap enkripsi ujung ke ujung dan privasi pengguna.

Rencana perlindungan untuk anak-anak oleh Apple adalah hal yang baik, tetapi itu juga mendapat kritik keras. Dengan dirilisnya macOS Monterey, iOS 15, dan iPad OS 15, perusahaan menerapkan deteksi CSAM (Materi Pelecehan Seksual Anak) yang akan memeriksa hash gambar untuk melihat apakah ada gambar yang disalahgunakan.

Teknologi tersebut telah disamakan dengan membuat pintu belakang ke file pengguna dan membuat para pakar privasi ketakutan. Dalam sebuah unggahan di bagian Child Safety di situs webnya, Apple mengatakan bahwa mereka ingin membantu melindungi anak-anak dari pemangsa yang menggunakan alat komunikasi untuk merekrut dan mengeksploitasi mereka, dan membatasi penyebaran CSAM.

Dengan pemikiran tersebut perusahaan berencana untuk memindai gambar yang dikirim melalui Pesan atau diunggah ke iCloud untuk gambar CSAM yang dikenal. Diketahui, Apple memperkenalkan fitur keselamatan anak baru di tiga area, yang dikembangkan bekerja sama dengan pakar keselamatan anak.

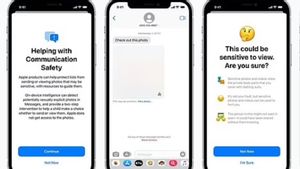

Pertama, alat komunikasi baru akan memungkinkan orang tua memainkan peran yang lebih terinformasi dalam membantu anak-anak mereka menavigasi komunikasi online. Aplikasi Message akan menggunakan pembelajaran mesin di perangkat untuk memperingatkan tentang konten sensitif, sekaligus menjaga komunikasi pribadi tidak dapat dibaca oleh Apple.

Selanjutnya, iOS dan iPadOS akan menggunakan aplikasi kriptografi baru untuk membantu membatasi penyebaran CSAM online, sambil merancang untuk privasi pengguna. Deteksi CSAM akan membantu Apple memberikan informasi berharga kepada penegak hukum tentang koleksi CSAM di iCloud Photos.

Terakhir, pembaruan fitur Siri dan Search memberikan informasi dan bantuan yang lebih luas kepada orang tua dan anak-anak jika mereka menghadapi situasi yang tidak aman. Fitur Siri dan Search juga akan campur tangan saat pengguna mencoba mencari topik terkait CSAM.

Ada beberapa langkah Apple yang mengkhawatirkan di sini, di antaranya adalah salah mendeteksi, karena hash gambar tidak unik, artinya gambar yang disalahgunakan dapat memiliki hash yang sama dengan sesuatu yang sama sekali tidak bersalah.

Pendukung privasi Electronic Frontier Foundation (EFF) menyatakan ini adalah pelanggaran privasi yang sangat besar. Rencana Apple untuk memindai foto yang diunggah ke iCloud Photos serupa dengan PhotoDNA Microsoft.

Perbedaannya adalah bahwa pemindaian Apple akan terjadi di perangkat. Basis data (tidak dapat diaudit) dari gambar CSAM yang diproses akan didistribusikan di OS, gambar yang diproses diubah sehingga pengguna tidak dapat melihat apa itu gambar.

BACA JUGA:

Ini berarti bahwa ketika fitur diluncurkan, versi database NCMEC CSAM akan diunggah ke setiap iPhone. Setelah sejumlah foto terdeteksi, foto tersebut akan dikirim ke peninjau manusia di Apple, yang nantinya menentukan bahwa foto tersebut sebenarnya adalah bagian dari basis data CSAM.

Jika dikonfirmasi oleh peninjau manusia, foto-foto itu akan dikirim ke NCMEC, dan akun pengguna akan dinonaktifkan. Sekali lagi, intinya di sini adalah bahwa apa pun aspek privasi dan keamanan dalam detail teknis, semua foto yang diunggah ke iCloud akan dipindai.