JAKARTA - Sebuah organisasi perlindungan anak mengungkapkan bahwa mereka menemukan lebih banyak kasus gambar pelecehan di platform Apple di Inggris daripada yang dilaporkan Apple secara global.

Pada tahun 2022, Apple membatalkan rencananya untuk mendeteksi Child Sexual Abuse Material (CSAM) setelah adanya tuduhan bahwa sistem tersebut akan digunakan untuk pengawasan semua pengguna.

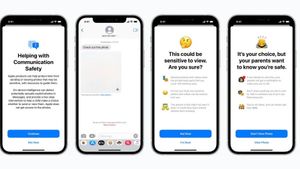

Apple kemudian memperkenalkan fitur yang disebut Communication Safety, yang secara otomatis memblokir dan memburamkan foto-foto telanjang yang dikirim kepada anak-anak.

Menurut surat kabar The Guardian, National Society for the Prevention of Cruelty to Children (NSPCC) di Inggris mengatakan bahwa Apple secara drastis mengurangi laporan insiden CSAM di layanan seperti iCloud, FaceTime, dan iMessage.

Semua perusahaan teknologi AS diwajibkan untuk melaporkan kasus CSAM yang terdeteksi ke National Center for Missing & Exploited Children (NCMEC), dan pada tahun 2023, Apple membuat 267 laporan.

Laporan tersebut diklaim sebagai deteksi CSAM secara global. Namun, NSPCC di Inggris secara independen menemukan bahwa Apple terlibat dalam 337 pelanggaran antara April 2022 dan Maret 2023 — hanya di Inggris dan Wales.

"Ada perbedaan yang mengkhawatirkan antara jumlah kejahatan gambar pelecehan anak yang terjadi di layanan Apple di Inggris dan jumlah laporan global konten pelecehan yang mereka buat kepada otoritas," kata Richard Collard, kepala kebijakan keamanan online anak di NSPCC.

"Apple jelas tertinggal dibandingkan banyak rekan mereka dalam menangani pelecehan seksual anak ketika semua perusahaan teknologi seharusnya berinvestasi dalam keamanan dan mempersiapkan peluncuran Undang-Undang Keamanan Online di Inggris," tambah Collard.

BACA JUGA:

Sebagai perbandingan, Google melaporkan lebih dari 1.470.958 kasus pada tahun 2023. Pada periode yang sama, Meta melaporkan 17.838.422 kasus di Facebook, dan 11.430.007 di Instagram.

Apple berkilah mereka tidak dapat melihat isi pesan iMessage pengguna karena layanan ini terenkripsi. Namun, NCMEC mencatat bahwa WhatsApp milik Meta juga terenkripsi, namun Meta melaporkan sekitar 1.389.618 kasus dugaan CSAM pada tahun 2023.

Sebagai tanggapan atas tuduhan tersebut, Apple dilaporkan hanya merujuk The Guardian pada pernyataan sebelumnya tentang privasi pengguna secara keseluruhan.

Beberapa ahli pelecehan anak juga khawatir tentang gambar CSAM yang dihasilkan oleh AI. Apple Intelligence yang akan datang tidak akan membuat gambar fotorealistik.