JAKARTA - Discord akhirnya menghadirkan fitur baru untuk melindungi para pengguna mereka yang masih di bawah umur. Fitur ini mereka perkenalkan lewat program Teen Safety Assist.

Teen Safety Assist merupakan salah satu upaya Discord dalam memberantas materi pelecehan seksual pada anak (CSAM) di platform mereka. Upaya ini juga dilakukan untuk melindungi remaja dari predator dewasa.

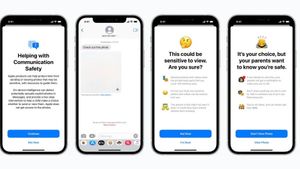

Program Teen Safety Assist memiliki dua fitur di dalamnya, yaitu Peringatan Otomatis dan filter konten. Kedua fitur ini telah diatur secara default atau otomatis pada sistem mereka.

Saat seorang remaja mendapatkan pesan oleh pengguna yang tidak dikenali, peringatan akan dimunculkan secara otomatis, terlebih saat Discord mendeteksi bahaya dari pesan pihak pertama.

Remaja yang mendapatkan pesan dari orang asing akan diarahkan kepada tiga pilihan, di antaranya menanggapi pesan, memblokir akun, atau tips keselamatan terkait.

Sementara itu, gambar sensitif yang dikirim seseorang kepada remaja akan di-blur secara otomatis dengan filter konten. Selain di-blur, gambar sensitif ini secara otomatis akan terhapus.

BACA JUGA:

Fitur ini bisa dimatikan melalui Pengaturan dan bisa diaktifkan bagi orang dewasa yang memerlukannya. Dengan kata lain, filter ini bisa berguna untuk seluruh pengguna platformnya.

Discord mulai fokus pada masalah CSAM setelah NBC News menemukan adanya 165 kasus penuntutan atas CSAM melalui platform Discord. Bahkan, sejumlah orang dewasa memaksa para remaja untuk mengirim gambar seksual.

Setelah masalah ini menjadi serius, Discord mulai melarang server kencan remaja dan melarang pembagian CSAM yang dibuat dengan Kecerdasan Buatan (AI). Discord juga memperkenalkan dasbor khusus orang tua untuk melacak cara bermain anaknya di Discord.