JAKARTA - Platform media sosial Reddit mengumumkan pada Selasa, 25 Juni, bahwa mereka akan memperbarui standar web yang digunakan oleh platform tersebut untuk mencegah pengumpulan data otomatis dari situs webnya. Langkah ini diambil setelah laporan menyebutkan bahwa startup AI telah mengakali aturan tersebut untuk mengumpulkan konten bagi sistem mereka.

Pengumuman ini muncul pada saat perusahaan-perusahaan kecerdasan buatan (AI) dituduh melakukan plagiarisme konten dari penerbit untuk membuat ringkasan AI tanpa memberikan kredit atau meminta izin.

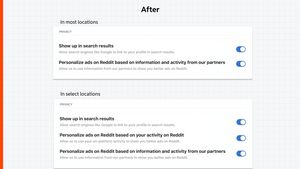

Reddit menyatakan akan memperbarui Robots Exclusion Protocol, atau "robots.txt," standar yang diterima secara luas yang bertujuan untuk menentukan bagian mana dari situs yang boleh diindeks oleh mesin pencari. Perusahaan juga akan mempertahankan pembatasan kecepatan, teknik yang digunakan untuk mengontrol jumlah permintaan dari satu entitas tertentu, dan akan memblokir bot dan crawler yang tidak dikenal dari pengumpulan data di situs webnya.

Baru-baru ini, robots.txt menjadi alat penting yang digunakan oleh penerbit untuk mencegah perusahaan teknologi menggunakan konten mereka secara gratis untuk melatih algoritma AI dan membuat ringkasan sebagai tanggapan terhadap beberapa kueri pencarian.

BACA JUGA:

Minggu lalu, sebuah surat kepada penerbit oleh startup lisensi konten TollBit mengatakan bahwa beberapa perusahaan AI mengakali standar web untuk mengumpulkan data dari situs penerbit.

Hal ini mengikuti penyelidikan oleh Wired yang menemukan bahwa startup pencarian AI, Perplexity, kemungkinan mengakali upaya untuk memblokir crawler web mereka melalui robots.txt.

Pada awal Juni, penerbit media bisnis Forbes menuduh Perplexity melakukan plagiarisme terhadap cerita investigatifnya untuk digunakan dalam sistem AI generatif tanpa memberikan kredit.

Reddit juga menyatakan pada Selasa bahwa peneliti dan organisasi seperti Internet Archive akan tetap memiliki akses ke kontennya untuk penggunaan non-komersial.