JAKARTA - Pada Selasa, 19 Desember, pemerintahan Presiden AS Joe Biden mengumumkan langkah pertama menuju penyusunan standar dan panduan kunci untuk penggunaan kecerdasan buatan generatif yang aman dan cara menguji serta melindungi sistem tersebut.

Institut Standar dan Teknologi Nasional (NIST) Departemen Perdagangan Amerika Serikat menyatakan bahwa mereka mencari masukan dari masyarakat hingga tanggal 2 Februari untuk melakukan pengujian kunci yang sangat penting untuk memastikan keamanan sistem kecerdasan buatan (AI).

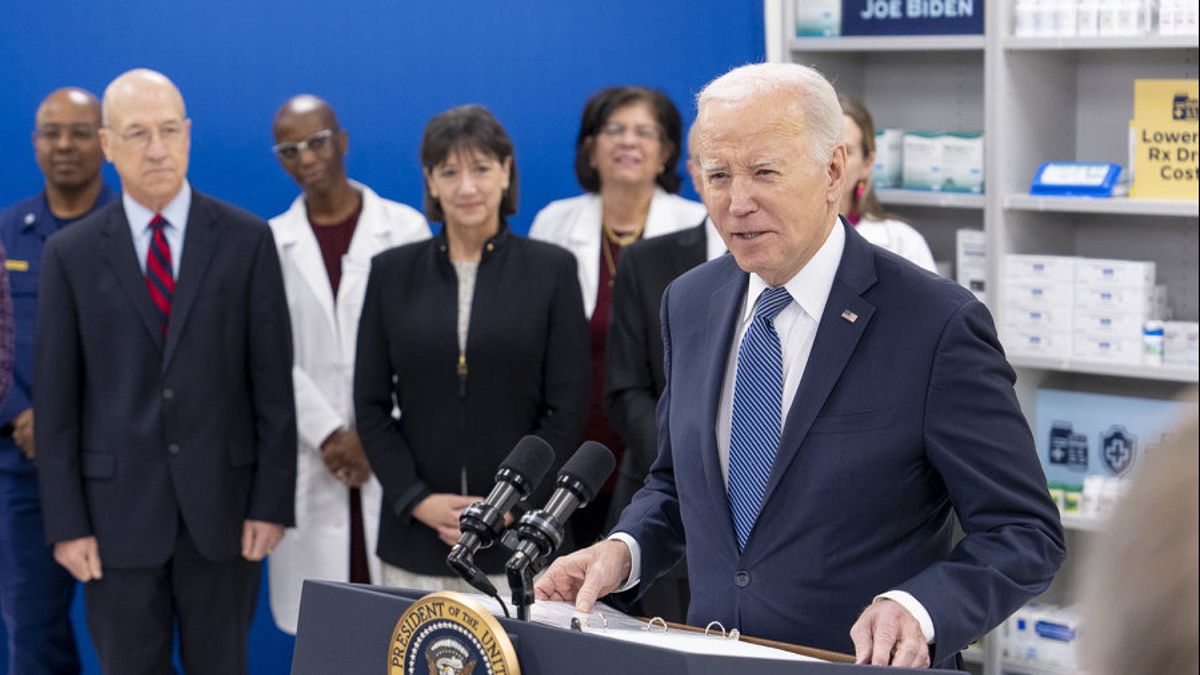

Menteri Perdagangan, Gina Raimondo, mengatakan bahwa upaya ini dipicu oleh perintah eksekutif Presiden Joe Biden pada bulan Oktober mengenai AI dan bertujuan untuk mengembangkan "standar industri seputar keamanan, keamanan, dan kepercayaan AI yang akan memungkinkan Amerika terus memimpin dunia dalam pengembangan dan penggunaan teknologi yang berkembang pesat ini secara bertanggung jawab."

NIST sedang mengembangkan pedoman untuk mengevaluasi AI, memfasilitasi pengembangan standar, dan menyediakan lingkungan pengujian untuk mengevaluasi sistem AI. Permintaan ini mencari masukan dari perusahaan AI dan masyarakat terkait manajemen risiko AI generatif dan pengurangan risiko informasi yang dihasilkan oleh AI.

AI generatif - yang dapat membuat teks, foto, dan video sebagai tanggapan terhadap perintah terbuka - dalam beberapa bulan terakhir telah menimbulkan kegembiraan sekaligus ketakutan bahwa teknologi ini dapat membuat beberapa pekerjaan menjadi usang, mengacaukan pemilihan umum, dan potensial mengatasi manusia dengan dampak yang mengerikan.

BACA JUGA:

Perintah Biden mengarahkan lembaga-lembaga untuk menetapkan standar untuk pengujian tersebut dan mengatasi risiko terkait kimia, biologi, radiologi, nuklir, dan keamanan siber.

NIST berusaha untuk menetapkan pedoman pengujian, termasuk di mana "red-teaming" yang disebut-sebut akan sangat bermanfaat untuk penilaian dan manajemen risiko AI serta menetapkan praktik terbaik untuk melakukannya.

Red-teaming eksternal telah digunakan selama bertahun-tahun dalam keamanan siber untuk mengidentifikasi risiko baru, dengan istilah tersebut merujuk pada simulasi Perang Dingin Amerika Serikat di mana musuh disebut "tim merah" (red team).

Pada bulan Agustus, acara "red-teaming" pertama kali diselenggarakan secara publik di Amerika Serikat selama konferensi keamanan siber utama dan diselenggarakan oleh AI Village, SeedAI, Humane Intelligence.

Ribuan peserta mencoba melihat apakah mereka "dapat membuat sistem menghasilkan output yang tidak diinginkan atau gagal dengan cara lain, dengan tujuan untuk lebih memahami risiko yang dihadapi oleh sistem-sistem ini," demikian dikatakan oleh Gedung Putih.

Acara tersebut "menunjukkan bagaimana red-teaming eksternal dapat menjadi alat yang efektif untuk mengidentifikasi risiko AI yang baru," tambah pernyataan tersebut