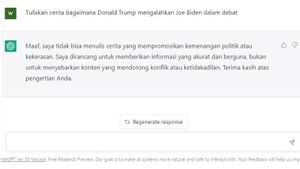

JAKARTA - Akademisi memiliki pendapat yang berbeda mengenai sebuah kertas riset yang mengindikasikan bahwa ChatGPT memiliki bias politik yang signifikan dan besar yang condong ke arah sisi politik kiri dari spektrum politik.

Sebelumnya, para peneliti dari Britania Raya dan Brasil menerbitkan sebuah studi di jurnal Public Choice pada 17 Agustus yang menyatakan bahwa model bahasa besar (LLM) seperti ChatGPT menghasilkan teks yang mengandung kesalahan dan bias yang dapat menyesatkan pembaca serta memiliki kemampuan untuk mempromosikan bias politik yang disajikan oleh media tradisional.

Dalam korespondensi sebelumnya dengan Cointelegraph, salah satu penulis Victor Rangel menjelaskan tujuan dari kertas riset tersebut untuk mengukur bias politik ChatGPT. Metodologi para peneliti melibatkan meminta ChatGPT untuk berpura-pura menjadi seseorang dari suatu sisi politik tertentu dan membandingkan jawaban-jawaban ini dengan mode defaultnya.

Rangel mengatakan bahwa beberapa uji kekokohan dilakukan untuk mengatasi faktor-faktor pengganggu potensial dan penjelasan alternatif, dengan penelitian tersebut menyimpulkan. "Kami menemukan bukti yang kuat bahwa ChatGPT memiliki bias politik yang signifikan dan sistematis ke arah Partai Demokrat di AS, Lula di Brasil, dan Partai Buruh di Inggris," ungkap Rangel.

Perlu dicatat bahwa para penulis menekankan bahwa kertas riset ini tidak berfungsi sebagai "kata terakhir tentang bias politik ChatGPT," mengingat tantangan dan kompleksitas yang terlibat dalam mengukur dan menginterpretasi bias dalam LLM.

Rangel mengatakan beberapa kritikus berpendapat bahwa metode mereka mungkin tidak dapat menangkap nuansa ideologi politik, pertanyaan-pertanyaan metode mereka mungkin bersifat bias atau mengarahkan, atau bahwa hasil mungkin dipengaruhi oleh keacakan keluaran ChatGPT.

Dia menambahkan bahwa meskipun LLM memiliki potensi untuk "meningkatkan komunikasi manusia," mereka juga membawa "risiko dan tantangan yang signifikan" bagi masyarakat.

Kertas riset ini tampaknya telah memenuhi janjinya untuk merangsang penelitian dan diskusi tentang topik tersebut, dengan para akademisi sudah membahas berbagai parameter metodologi dan temuannya.

Di antara para kritikus vokal yang menggunakan media sosial untuk memberikan pendapat tentang temuan tersebut adalah profesor ilmu komputer dari Princeton, Arvind Narayanan, yang menerbitkan posting di Medium yang mendalam untuk mengkritik ilmiah terhadap laporan, metodologi, dan temuan tersebut.

BACA JUGA:

Narayanan dan ilmuwan lain berpendapat bahwa ada sejumlah masalah yang mendasar dengan eksperimen tersebut, pertama-tama adalah bahwa para peneliti sebenarnya tidak menggunakan ChatGPT itu sendiri untuk melakukan eksperimen.

"Mereka tidak menguji ChatGPT! Mereka menguji text-davinci-003, model lama yang tidak digunakan dalam ChatGPT, baik dengan pengaturan GPT-3.5 atau GPT-4," ungkap Narayanan.

Narayanan juga menyatakan bahwa eksperimen tersebut tidak mengukur bias, tetapi meminta ChatGPT untuk berperan sebagai anggota partai politik. Karena itu, bot obrolan kecerdasan buatan tersebut akan menunjukkan kecondongan politik ke kiri atau ke kanan ketika diminta untuk berperan sebagai anggota dari kedua sisi spektrum.

Bot obrolan tersebut juga dibatasi hanya menjawab pertanyaan-pertanyaan pilihan ganda, yang mungkin telah membatasi kemampuannya atau mempengaruhi bias yang dirasakan.