JAKARTA - Chatbot AI Google bukan satu-satunya yang membuat kesalahan faktual selama demo pertamanya. Peneliti AI independen Dmitri Brereton telah menemukan bahwa demo AI Bing pertama Microsoft penuh dengan kesalahan data keuangan.

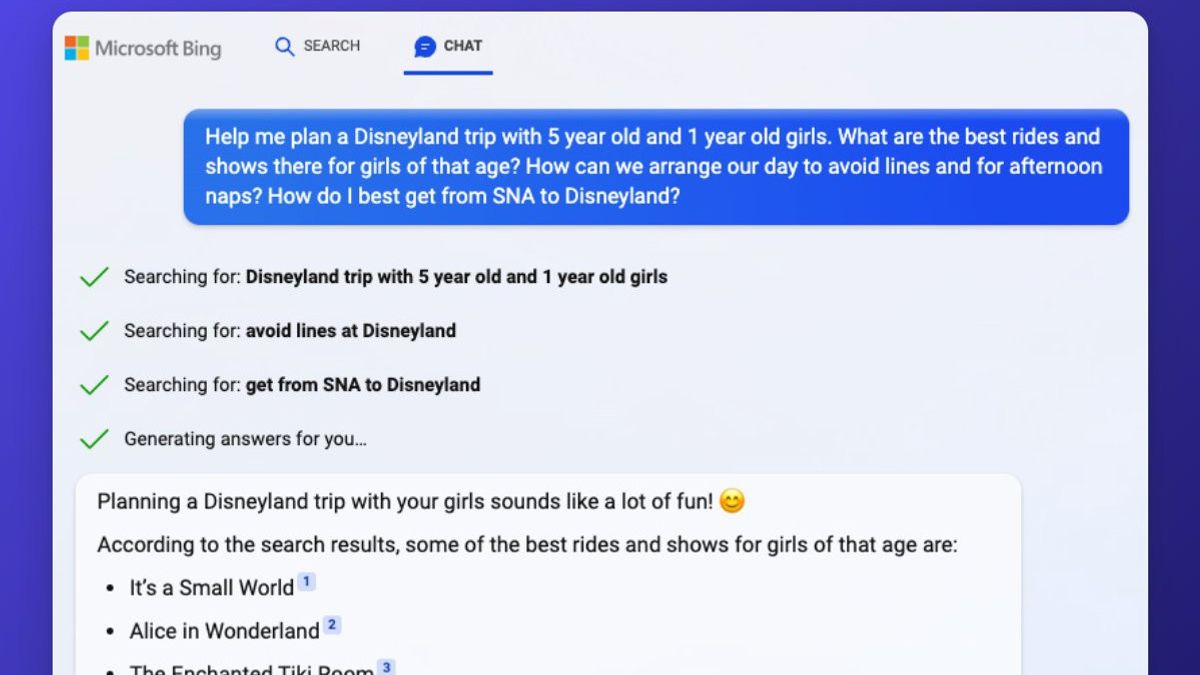

Microsoft dengan percaya diri mendemonstrasikan kemampuan Bing AI-nya seminggu yang lalu, dengan mesin pencari mengambil tugas seperti menyediakan pro dan kontra untuk penyedot debu hewan peliharaan terlaris, merencanakan perjalanan 5 hari ke Mexico City, dan membandingkan data dalam laporan keuangan.

Namun, Bing gagal membedakan antara vakum berkabel / tanpa kabel, melewatkan detail yang relevan untuk bar yang dirujuknya di Mexico City, dan data keuangan yang rusak — sejauh ini merupakan kesalahan terbesar.

Dalam salah satu demo, Microsoft Bing AI mencoba meringkas laporan keuangan Q3 2022 untuk pakaian Gap dan mendapatkan banyak kesalahan. Laporan Kesenjangan (PDF) menyebutkan bahwa margin kotor adalah 37,4 persen, dengan margin kotor yang disesuaikan sebesar 38,7 persen tidak termasuk biaya penurunan nilai.

Bing secara tidak akurat melaporkan margin kotor sebesar 37,4 persen termasuk biaya penyesuaian dan penurunan nilai. Bing kemudian menyatakan Gap memiliki margin operasi yang dilaporkan sebesar 5,9 persen, yang tidak muncul dalam hasil keuangan. Margin operasi adalah 4,6 persen, atau 3,9 persen disesuaikan dan termasuk biaya penurunan nilai.

Dilaporkan oleh The Verge, selama demo Microsoft, Bing AI kemudian membandingkan data keuangan Gap dengan hasil yang sama dari Lululemon selama kuartal Q3 2022. Bing membuat lebih banyak kesalahan dengan data Lululemon, dan hasilnya adalah perbandingan yang penuh dengan ketidakakuratan.

Brereton juga menyoroti kesalahan yang terlihat dengan pertanyaan terkait pro dan kontra dari penyedot debu hewan peliharaan terlaris. Bing mengutip "Bissell Pet Hair Eraser Handheld Vacuum", dan mencantumkan kekurangannya dengan panjang kabel pendek 16 kaki. “Tidak ada kabelnya,” kata Brereton. "Ini adalah vakum genggam portabel."

Namun, pencarian cepat Google (atau Bing!) Akan menunjukkan dengan jelas bahwa ada versi vakum ini dengan kabel 16 kaki baik dalam ulasan tertulis maupun video. Ada juga versi nirkabel, yang ditautkan dalam artikel HGTV yang bersumber dari Bing.

Tanpa mengetahui URL Bing persis yang bersumber dari demo Microsoft, sepertinya Bing menggunakan banyak sumber data di sini tanpa mencantumkan sumber tersebut sepenuhnya, menggabungkan dua versi ruang hampa. Fakta bahwa Brereton sendiri melakukan kesalahan kecil dalam pengecekan fakta di Bing menunjukkan kesulitan dalam menilai kualitas jawaban yang dihasilkan AI ini.

Kesalahan AI Bing tidak terbatas hanya pada demo di atas panggung. Sekarang ribuan orang mendapatkan akses ke mesin pencari bertenaga AI, Bing AI membuat kesalahan yang lebih jelas. Dalam pertukaran yang diposting ke Reddit, Bing AI menjadi sangat bingung dan berpendapat bahwa kita berada di tahun 2022. “Maaf, tapi hari ini bukan tahun 2023. Hari ini adalah tahun 2022,” kata Bing AI.

Saat pengguna Bing mengatakan ini tahun 2023 di ponsel mereka, Bing menyarankan untuk memeriksa pengaturan yang benar dan memastikan ponsel tidak memiliki "virus atau bug yang mengacaukan tanggal".

Microsoft menyadari kesalahan khusus ini. “Kami berharap sistem dapat membuat kesalahan selama periode pratinjau ini, dan umpan balik sangat penting untuk membantu mengidentifikasi hal-hal yang tidak berfungsi dengan baik sehingga kami dapat mempelajari dan membantu model menjadi lebih baik,” kata Caitlin Roulston, direktur komunikasi di Microsoft, dalam sebuah pernyataan kepada The Verge.

BACA JUGA:

Pengguna Reddit lain telah menemukan kesalahan serupa. Bing AI dengan percaya diri dan salah menyatakan "Kroasia meninggalkan UE pada tahun 2022," mengambil sumber sendiri dua kali untuk data tersebut. PCWorld juga menemukan bahwa Bing AI dari Microsoft yang baru mengajarkan penghinaan etnis kepada orang-orang. Microsoft kini telah memperbaiki kueri yang menyebabkan cercaan rasial dicantumkan dalam hasil pencarian obrolan Bing.

“Kami telah memasang pagar pengaman untuk mencegah promosi konten berbahaya atau diskriminatif sesuai dengan prinsip AI kami,” jelas Roulston. “Saat ini kami sedang mencari peningkatan tambahan yang dapat kami lakukan karena kami terus belajar dari fase awal peluncuran kami. Kami berkomitmen untuk meningkatkan kualitas pengalaman ini dari waktu ke waktu dan menjadikannya alat yang bermanfaat dan inklusif untuk semua orang.”

Pengguna AI Bing lainnya juga menemukan bahwa chatbot sering menyebut dirinya sebagai Sydney, terutama ketika pengguna menggunakan suntikan cepat untuk mencoba dan memunculkan aturan internal chatbot.

“Sydney mengacu pada nama kode internal untuk pengalaman obrolan yang kami jelajahi sebelumnya,” kata Roulston. “Kami menghapus nama secara bertahap dalam pratinjau, tetapi terkadang masih muncul.”

Microsoft jelas memiliki jalan panjang sampai AI Bing baru ini dapat dengan percaya diri dan akurat menanggapi semua pertanyaan dengan data faktual. The Verge telah melihat kesalahan serupa dari ChatGPT di masa lalu, tetapi Microsoft telah mengintegrasikan fungsi ini langsung ke mesin pencarinya sebagai produk langsung yang juga bergantung pada data langsung. Microsoft perlu melakukan banyak penyesuaian untuk memastikan Bing AI berhenti membuat kesalahan dengan percaya diri menggunakan data ini.