雅加达-苹果刚刚收到一封公开信,谴责该公司取消扫描Mac,iPad和iPhone用户的照片作为虐待儿童的证据。

这封信由隐私倡导者、安全专家、技术公司和法律专家签署。在信中,他们提到苹果目前的举动可能会破坏技术专家、学者和政策倡导者数十年来在加强隐私保护措施方面所从事的工作,这些措施已成为大多数消费类电子设备和使用案例的常态。

信中援引贝塔新闻8月9日星期一的话说:"我们要求苹果重新考虑其技术的推出,以免撤消这项重要工作。

签署国提交了两项请求,苹果提议的内容监控技术立即停止应用。苹果应该发布一份声明,重申他们对端到端加密和用户隐私的承诺。

苹果的儿童保护计划是一件好事,但它也受到严厉批评。随着macOS蒙特利,iOS 15和iPad操作系统15的发布,该公司实施了CSAM(儿童性虐待材料)检测,检查图像有没有被滥用。

这项技术被比作创建用户文件的后门和可怕的隐私专家。苹果在上传到其网站的儿童安全部分时表示,它希望帮助保护儿童免受使用通信工具招募和利用的掠食者的攻击,并限制CSAM的传播。

有鉴于此,公司计划扫描通过消息发送或上传到 iCloud 的已知 CSAM 图像的图像。众所周知,苹果与儿童安全专家合作开发的三个领域引入了新的儿童安全功能。

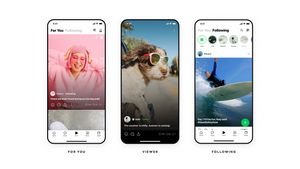

首先,新的通信工具将允许家长在帮助孩子浏览在线通信方面发挥更明智的作用。消息应用程序将使用设备上的机器学习来警告敏感内容,同时保持 Apple 无法读取个人通信。

接下来,iOS 和 iPadOS 将使用新的加密应用程序来帮助限制在线 CSAM 的传播,同时为用户隐私进行设计。CSAM 检测可帮助 Apple 向执法部门提供有关 iCloud 照片中 CSAM 集合的宝贵信息。

最后,Siri 和 Search 功能更新为家长和儿童在遇到不安全情况时提供更广泛的信息和帮助。当用户尝试搜索与 CSAM 相关的主题时,Siri 和搜索功能也会进行干预。

这里有一些令人震惊的苹果步骤,其中包括误检测,因为图像哈希不是独一无二的,这意味着被滥用的图像可以有相同的哈希作为完全无辜的东西。

电子前沿基金会(EFF)的隐私倡导者说,这是一个巨大的侵犯隐私的行为。苹果扫描上传到 iCloud 照片的照片的计划与微软的 PhotoDNA 类似。

不同的是,苹果扫描将发生在设备上。处理过的 CSAM 图像的数据库(未经审计)将在操作系统中分发,已处理的图像将被更改,以便用户看不到图像是什么。

这意味着,当功能推出时,NCMEC CSAM数据库版本将上传到每个iPhone。一旦检测到许多照片,它们将被发送到 Apple 的人类审查员,后者后来确定它们实际上是 CSAM 数据库的一部分。

如果得到人类审查员的确认,照片将被发送到 NCMEC,用户帐户将被禁用。同样,这里的底线是,无论技术细节中的隐私和安全方面如何,上传到 iCloud 的所有照片都将进行扫描。

The English, Chinese, Japanese, Arabic, and French versions are automatically generated by the AI. So there may still be inaccuracies in translating, please always see Indonesian as our main language. (system supported by DigitalSiber.id)