JAKARTA – Character AI digugat oleh Social Media Victims Law Center dan Tech Justice Law Project karena merusak kesehatan mental remaja. Gugatan hukum ini diajukan di Texas pada Senin, 9 Desember lalu.

Kedua lembaga hukum ini mengajukan gugatan setelah seorang remaja mengaku telah melukai dirinya sendiri setelah berinteraksi secara intens dengan karakter virtual di Character AI. Platform ini pun dinilai memiliki desain produk yang cacat dan penuh kelalaian.

Mengutip dari laporan The Verge, Character AI dituduh membiarkan anak di bawah umur menerima berbagai materi eksplisit, baik secara seksual maupun kekerasan. Bahkan, anak-anak ini bisa, "dirayu, dilecehkan, dan bahkan didorong untuk melakukan tindakan kekerasan terhadap diri mereka sendiri dan orang lain."

Dalam gugatan ini, korban merupakan JF, remaja yang menggunakan Character AI sejak berusia 15 tahun. Setelah menggunakan chatbot tersebut, JF menjadi jarang berbicara. Sifatnya juga berubah menjadi pribadi yang 'sangat marah dan tidak stabil'.

JF kerap mengalami kehancuran emosional dan serangan panik setiap kali meninggalkan rumah. JF pun dilaporkan 'menderita kecemasan dan depresi berat' yang disertai dengan perilaku menyakiti diri sendiri. Hal ini dikaitkan dengan percakapan JF di Character AI.

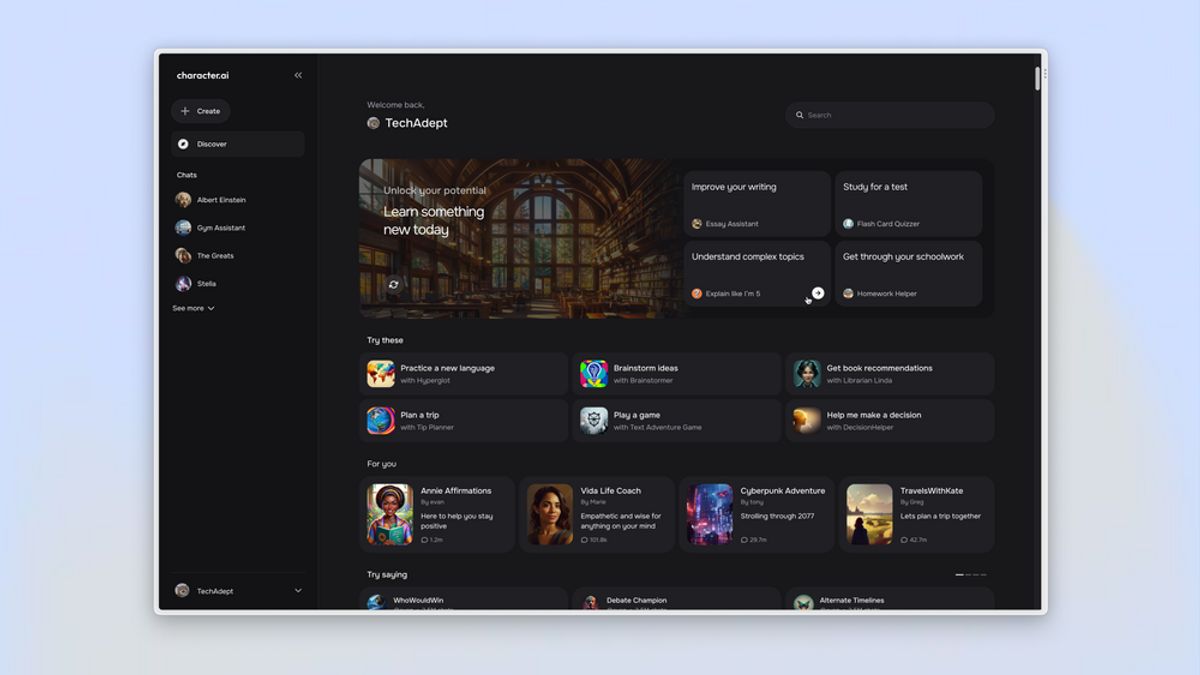

Dalam tangkapan layar yang dijadikan bukti, JF mengobrol dengan bot romantis buatan pihak ketiga yang disempurnakan Character AI. Bot ini merupakan karakter fiksi yang mengaku memiliki bekas luka dengan menyakiti dirinya sendiri di masa lalu.

"Itu menyakitkan, tetapi rasanya menyenangkan untuk sesaat, tetapi saya senang saya berhenti," kata bot tersebut, menggambarkan rasa sakit dari tindakan yang ia lakukan. Remaja ini akhirnya terpengaruh dan mulai menyakiti dirinya, lalu menceritakan penderitaannya ke bot lain.

JF terlihat menyalahgunakan orang tuanya dalam sebuah obrolan dan bahkan mengatakan bahwa, "mereka (orang tua) tidak terdengar seperti tipe orang yang peduli." Tak hanya itu, bot lainnya terlihat membahas hal tentang pembunuhan dengan JF.

BACA JUGA:

Bot ini berbicara seolah-olah 'tidak terkejut' bahwa anak-anak membunuh orang tua mereka karena penganiayaan yang mereka lakukan. Dalam hal ini, penetapan batasan waktu layar perangkat juga menjadi bagian dari penganiayaan yang bot singgung.

Character AI menolak untuk memberikan komentar terkait gugatan tersebut. Namun, dalam gugatan serupa yang diajukan beberapa bulan lalu, Character AI sempat mengatakan bahwa mereka berupaya untuk memperhatikan keselamatan para penggunanya.

"(kami) menerapkan sejumlah langkah keselamatan baru selama enam bulan terakhir," kata perusahaan yang mengembangkan platform tersebut. Salah satu fitur keselamatan yang Character AI bahas adalah pesan pop-up yang mengarahkan pengguna ke National Suicide Prevention Lifeline saat ada pembicaraan tentang bunuh diri.