ジャカルタ - 12月19日火曜日、Joe Biden米国大統領政権は、生成人工知能の安全な使用とそのようなシステムをテストして保護する方法のための主要な基準とガイドラインの確立に向けた最初のステップを発表しました。

米国商務省の国立標準技術研究所(NIST)は、人工知能(AI)システムのセキュリティを確保するために重要な重要なテストを実施するために、2月2日まで一般からの意見を求めていると発表した。

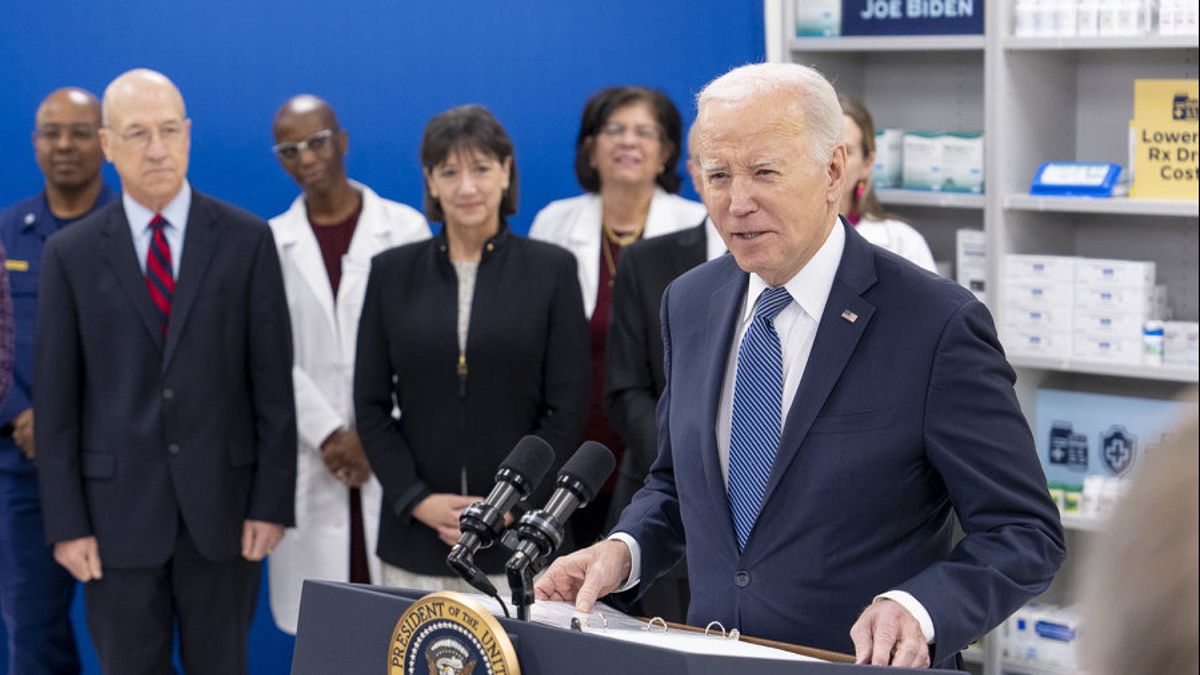

Gina Raimondo商務長官は、この取り組みはJoe Biden大統領のAIに関する10月の大統領令によって促されたもので、「米国がAIの開発と利用において世界をリードし続けることを可能にする、AIの安全性、セキュリティ、信頼性に関する業界標準を開発することを目的としている」と述べた。 責任を持って急速に成長するテクノロジー」。

NIST は、AI を評価するためのガイドラインを開発し、標準の開発を促進し、AI システムを評価するためのテスト環境を提供しています。 このリクエストは、AI 生成リスク管理と AI 生成情報のリスク軽減に関する AI 企業と一般の人々からの意見を求めています。

オープンなコマンドに応じてテキスト、写真、ビデオを作成できる生成 AI は、このテクノロジーが一部の仕事を時代遅れにし、選挙を混乱させ、悲惨な結果をもたらして人間を圧倒する可能性があるのではないかという興奮と恐怖の両方をここ数カ月で高めている。

Bidenの命令は各政府機関に対し、こうした検査の基準を設定し、化学、生物学、放射線、核、サイバーセキュリティーに関連するリスクに対処するよう指示している。

NIST は、宣伝されている「レッドチーム」が AI のリスク評価と管理に最も有益である場合や、そのためのベスト プラクティスの確立など、テスト ガイドラインの確立を目指しています。

外部のレッドチームは、サイバーセキュリティにおいて新たなリスクを特定するために長年使用されてきました。この用語は、敵対者を「レッドチーム」と呼んだ米国の冷戦シミュレーションを指します。

8月には、AI Village、SeedAI、Humane Intelligenceが主催し、米国の主要なサイバーセキュリティ会議中に初の「レッドチーム」イベントが公に開催された。

ホワイトハウスによると、数千人の参加者が「システムが直面するリスクをより深く理解することを目的として、システムが望ましくない出力を生成したり、他の方法で失敗したりできるかどうか」を確認しようとしたという。

このイベントは「外部のレッドチームが新たなAIリスクを特定するための効果的なツールとなり得ることを実証する」と声明では付け加えた。

The English, Chinese, Japanese, Arabic, and French versions are automatically generated by the AI. So there may still be inaccuracies in translating, please always see Indonesian as our main language. (system supported by DigitalSiber.id)