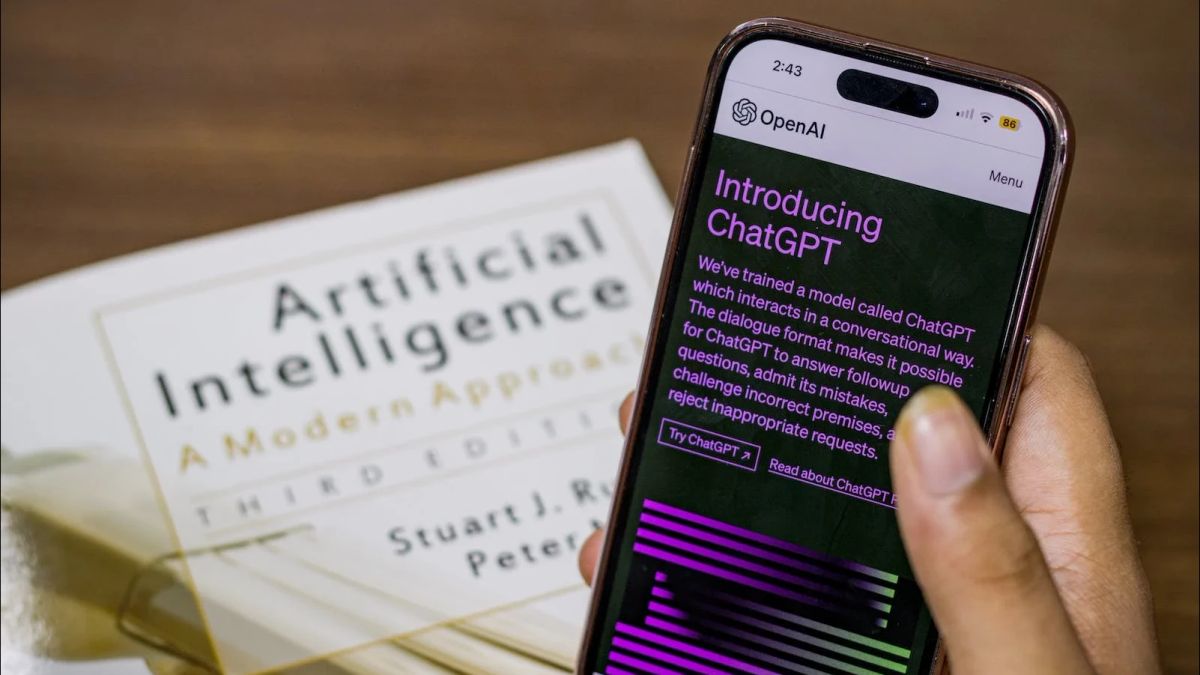

ジャカルタ-報告によると、ChatGPTは一般の人々がサイバー攻撃を実行するために使用できることが示唆されています。この欠点により、ユーザーはAIチャットボットに、データベースをハッキングして機密情報を盗む可能性のある悪意のあるコードを書き留めるように依頼できます。

研究者らは、人々が気づかずに誤ってそれを行い、主要なコンピュータシステムをクラッシュさせる可能性があるという最大の懸念を明らかにしました。

たとえば、看護師はChatGPTに臨床記録の検索を手伝うように頼むことができ、警告なしに組織を混乱させる可能性のある悪意のあるコードが与えられていることを知りません。

シェフィールド大学のチームは、チャットボットは非常に複雑だったため、それを製造した企業を含む多くの関係者が、彼らがもたらす脅威を「認識していない」と述べました。

この研究は、政府間AI安全サミットの約1週間前に、テクノロジーを安全に使用する方法について発表されました。

ChatGPTの背後にいる米国のスタートアップであるOpenAIは、問題が報告された後、特定の抜け穴を修正したと述べた。

しかし、コンピュータサイエンス部のシェフィールドのチームは、より多くの抜け穴がある可能性が高いと述べ、サイバーセキュリティ業界にこの問題をより詳細に検討するよう求めた。

この研究は、AIと呼ばれる「テキストからテキストへ」システムが、自然言語で尋ねることによってデータベースを探すことができることを最初に示しました - 現実世界のコンピュータシステムを攻撃するために使用することができます。

研究者は合計5つの商用AIツールを分析し、それらが実行されると機密情報を漏らし、サービスを混乱させたり破壊したりする可能性のある悪意のあるコードを生成できることを発見しました。

この発見は、専門のハッカーだけでなく、一般の人々もそのような攻撃を実行できるようになったことを示唆しています。

研究者たちは、これが無実のユーザーがそうしたことに気付きず、誤ってコンピュータシステムに感染する可能性があると懸念しています。

「実際、多くの企業はこの種の脅威を認識していないだけであり、チャットボットの複雑さのために、コミュニティ内でも、完全に理解されていないことがあります。現在、ChatGPTは多くの注目を集めています」と、この研究を主導したシェフィールド大学の修士課程の学生、Xutan Pengは述べています。

「ChatGPTはスタンドアロンシステムであるため、サービス自体へのリスクは最小限に抑えられますが、私たちが見つけたのは、このツールが他のサービスに深刻な損害を与える可能性のある悪意のあるコードを生成するために嘘をつく可能性があるということです」とPeng氏はDailyMailのVOIの発言を引用しました。

「ChatGPTのようなAIのリスクは、ますます多くの人々が会話ボットだけでなく、生産性ツールとして使用していることです。これは私たちの研究がその脆弱性を示す場所です」とPeng氏は付け加えました。

「たとえば、看護師はChatGPTにサイコントコマンドの作成を依頼して、臨床記録を保持するデータベースなどのデータベースと対話できるようにすることができます」と彼女は説明しました。

「私たちの調査で指摘されているように、ChatGPTによって生成されたCoinコードは多くの場合、データベースに損傷を与える可能性があるため、このシナリオの看護師は警告なしに重大なデータ管理エラーを引き起こす可能性があります」と彼は付け加えました。

この発見は、今月初めにイタリアのフィレンツェで開催されたソフトウェア信頼性エンジニアリング(ISSRE)に関する国際シンポジウムで発表されました。

研究者らはまた、AIを使用してプログラミング言語を学ぶ人々は、誤って破壊的なコードを作成する可能性があるため、危険であると警告しています。

「ChatGPTのようなAIのリスクは、ますます多くの人々が単なる会話ボットではなく、生産性ツールとして使用していることです。これは私たちの研究がその脆弱性を示す場所です」とPeng氏は述べています。

「現実には、多くの企業はこの種の脅威を認識していないため、チャットボットの複雑さのために、コミュニティ内でも完全に理解されていないことがあります。現在、ChatGPTは多くの注目を集めています」と彼は言いました。

英国のスエラ・ブレイバーマン内務長官は5月、米国国土安全保障省のアレハンドロ・マヨルカス氏と声明を発表し、「卑劣な方法で作成されたAI画像の憂慮すべき増加」に対処するための共同行動にコミットした。

一方、9月には、スペインの都市アルメンドラレホで裸の子供たちの写真を作成するために、シンプルなオープンソースツールを使用していたことが判明しました。

少女のソーシャルメディアから撮影された画像は、ヌード画像を生成するためのアプリケーションで処理され、20人の少女がアプリケーションの使用の犠牲者であると主張しました。

IWFは、この写真を作る際に身体的に拷問を受けた子供はいないが、犠牲者と正規化された略奪行動に重大な心理的損害があると警告している。

ほとんどのAI画像は、最も軽いカテゴリであるカテゴリCに分類されますが、5つの画像のうちの1つは、虐待の最も深刻な形式であるカテゴリAです。

The English, Chinese, Japanese, Arabic, and French versions are automatically generated by the AI. So there may still be inaccuracies in translating, please always see Indonesian as our main language. (system supported by DigitalSiber.id)