ジャカルタ-Twitterの代替としてソーシャルメディアとして適切であると主張されているマストドンは、児童性的虐待素材(CSAM)で満たされていることが判明しました。

スタンフォード大学のインターネット天文台が実施した新しい研究では、112ものCSAMコンテンツが、わずか2日間でプラットフォーム上の325,000の投稿にアップロードされたことがわかりました。

他のいくつかは5分間の検索の後に登場しました。研究者らは、コンテンツは非常にアクセス可能で、分散型サイトで検索できると述べています。

Google SafeSearch APIを武器に、研究者は、マークされたCSAMを見つけるのに役立つツールであるPhotoDNAの支援を受けて、露骨な画像を特定できます。

調査中、ハッシュタグやキーワードと一致する554のコンテンツを発見し、児童の性的虐待者がオンラインで頻繁に使用していました。彼らはまた、そのようなコンテンツをアップロードするためのグループを形成したと言われています。

「2日間で、ソーシャルメディア分析を行う上で、組織の歴史全体で考えていたよりも多くのフォトダナを得ましたが、それほど近づいていません」と、報告書の研究者の一人であるDavid Thielは、7月25日火曜日のThe Vergeから引用されたThe Washington Postに語った。

「その多くは、中央集権的なソーシャルメディアプラットフォームが子供の安全上の問題を解決するために使用するツールの不足の結果にすぎません」と彼は付け加えました。

すべては、Google SafeSearchによって最高の信頼を得ている露骨なコンテンツとして識別されました。また、メディアが含まれる投稿で、FediverseのCSAM関連ハッシュタグのトップ20から713の使用がありました。

彼らはまた、サイトや未成年者のケア以外のCSAM取引を指す1,217ものテキストアップロードのみを発見しました。

研究によると、CSAMの公開投稿は非常に一般的です。Gizmodoを立ち上げたFediverseは、ユーザーの自律性とプライバシーを優先するインタラクティブモデルの集中型所有権とガバナンスを回避するプラットフォームの緩やかな星座です。

Fediverseは、オープンソースと無料のWebプロトコルのセットで実行されており、誰でも自分のサーバーやエージェンシーを介してソーシャルコミュニティを管理およびホストできます。

Thiel氏は、Fediverseプラットフォームはこの問題に対して特に脆弱であると述べた「中央プラットフォームはコンテンツに対して最高の権限を持ち、可能な限りそれを停止する能力を持っていますが、Fediverseでは、悪意のあるアクターでサーバーを切り続けるだけで、コンテンツはまだ配布されており、依然として有害です」と彼は説明しました。

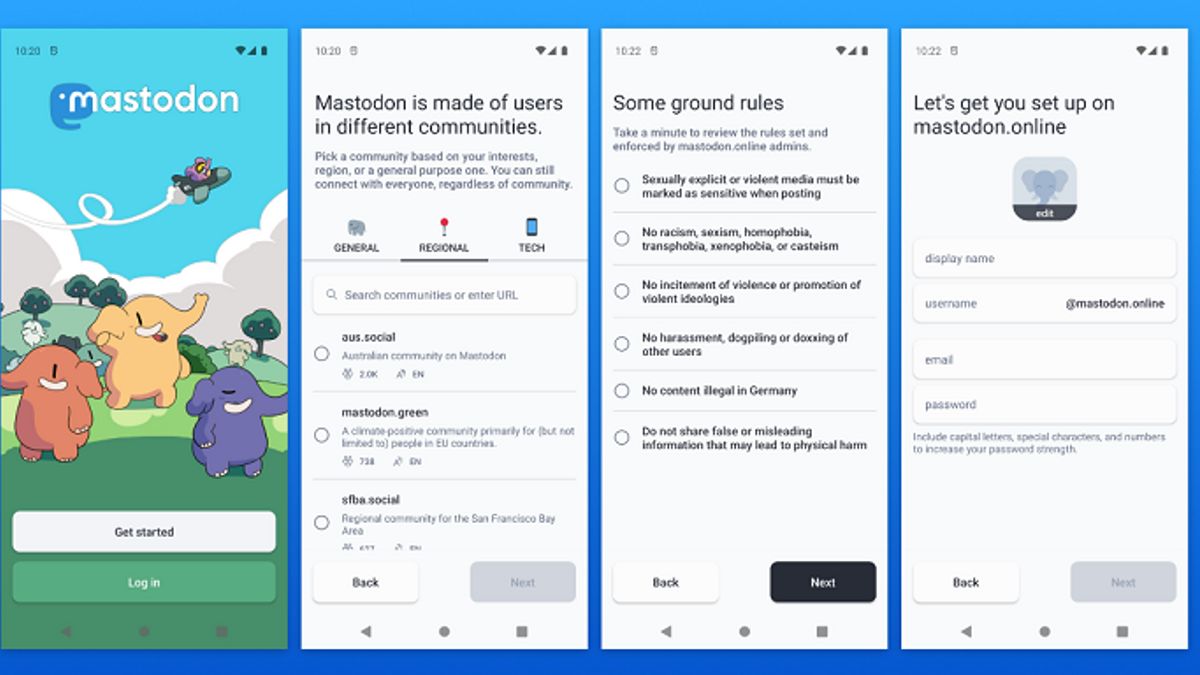

Mastodonのような分散型プラットフォームはますます人気が高まっており、セキュリティに関する懸念も高まっています。したがって、研究者たちは、Mastodonのようなネットワークはモデレーターのためにより強力なツールを使用することを提案しています。

The English, Chinese, Japanese, Arabic, and French versions are automatically generated by the AI. So there may still be inaccuracies in translating, please always see Indonesian as our main language. (system supported by DigitalSiber.id)