ジャカルタ-Googleの研究者は、今日の量子コンピューターに固有のエラーを修正できる新しいマイルストーンに到達しました。

Google Quantum AIの研究者は、システムサイズが大きくなるにつれてエラー率を下げる方法を見つけたと述べています。

「ですから、金融用語では、私たちは損益分岐点に達しましたが、それは確かに十分ではありませんでした。私たちは本当に低いエラー率を達成する必要があります」と、Google Quantum AIのエンジニアリングディレクターであるHartmut Neven博士は述べています。

Neven氏は、まだ課題はあるものの、現段階では量子コンピューターの商業的価値が約束されると確信していると付け加えた。

量子コンピューターは、量子物理学の特性を使用してデータを格納し、コンピューティングを実行します。従来のコンピュータの情報の基本単位はビットと呼ばれ、文字列1と0として格納されます。

量子コンピューター システムでは、これらの単位は量子ビットと呼ばれ、一度に 1 と 0 の両方を指定できます。理論的には、2月23日木曜日のインディペンデントから引用されているように、通常のコンピューターで数千年かかる計算を実行することで、量子マシンにはるかに大きな計算能力を提供します。

「量子プロセッサで物理量子ビットを 1 つずつ処理するのではなく、それらのグループを 1 つの論理量子ビットとして扱います。その結果、49個の物理量子ビットから作成した論理量子ビットは、17個の量子ビットから作成した量子ビットよりも優れた性能を発揮しました」と、AlphabetのCEOであるSundar Pichaiは同社の公式ブログで述べています。

Googleの量子コンピューターは、量子アルゴリズムと呼ばれる規制された方法で量子ビットを操作することによって機能します。課題は、量子ビットは非常に敏感であるため、迷光でさえ誤算につながる可能性があり、量子コンピューターが成長するにつれて問題が悪化することです。

「有用なアプリケーションを実行するために私たちが知っている最高の量子アルゴリズムでは、量子ビットのエラー率が現在よりもはるかに低い必要があるため、これは重大な結果をもたらします。このギャップを埋めるには、量子エラー訂正が必要です」とPichai氏は述べています。

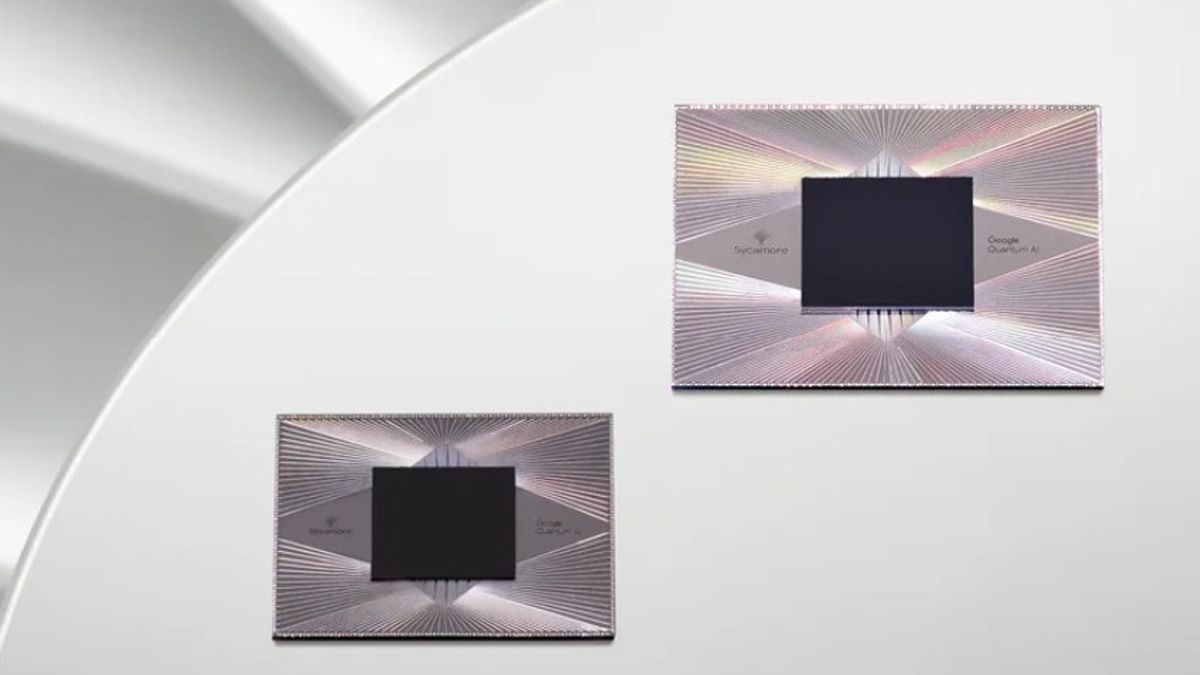

量子誤り訂正は、複数の物理量子ビット間で情報をエンコードして論理量子ビットを形成することで情報を保護し、Googleの研究者は、有用な計算に十分なエラー率で大規模な量子コンピューターを製造する唯一の方法であると考えています。彼らの研究は、2月22日水曜日にジャーナルNatureに掲載されました。

「量子コンピューターは、何百万人もの人々の生活に具体的な利益をもたらす可能性を秘めています。いつの日か、量子コンピューターを使用して、新薬の分子を特定し、肥料のエネルギー使用量を減らし、バッテリーから核融合炉までのより効率的な持続可能な技術を設計し、まだ想像できない進歩を生み出す物理学研究を生み出すと信じています」とピチャイ氏は説明しました。

Pichai氏は、同社はその強力な可能性を考慮して、責任を持って量子コンピューティングを開発するための措置を講じていると述べた。

「政府やセキュリティコミュニティとのパートナーシップは、将来の量子コンピューター攻撃からインターネットトラフィックを保護できるシステムの構築に役立ちます。そして、Google Cloud、Android、Chromeなどのサービスが量子の未来においても安全かつセキュアであり続けるようにしています」とPichai氏は締めくくりました。

The English, Chinese, Japanese, Arabic, and French versions are automatically generated by the AI. So there may still be inaccuracies in translating, please always see Indonesian as our main language. (system supported by DigitalSiber.id)