ジャカルタ-GoogleのAIチャットボットは、最初のデモで事実誤認を犯した唯一の人ではありませんでした。独立系AI研究者のDmitri Breretonは、マイクロソフトの最初のBing AIデモが財務データのエラーに満ちていることを発見しました。

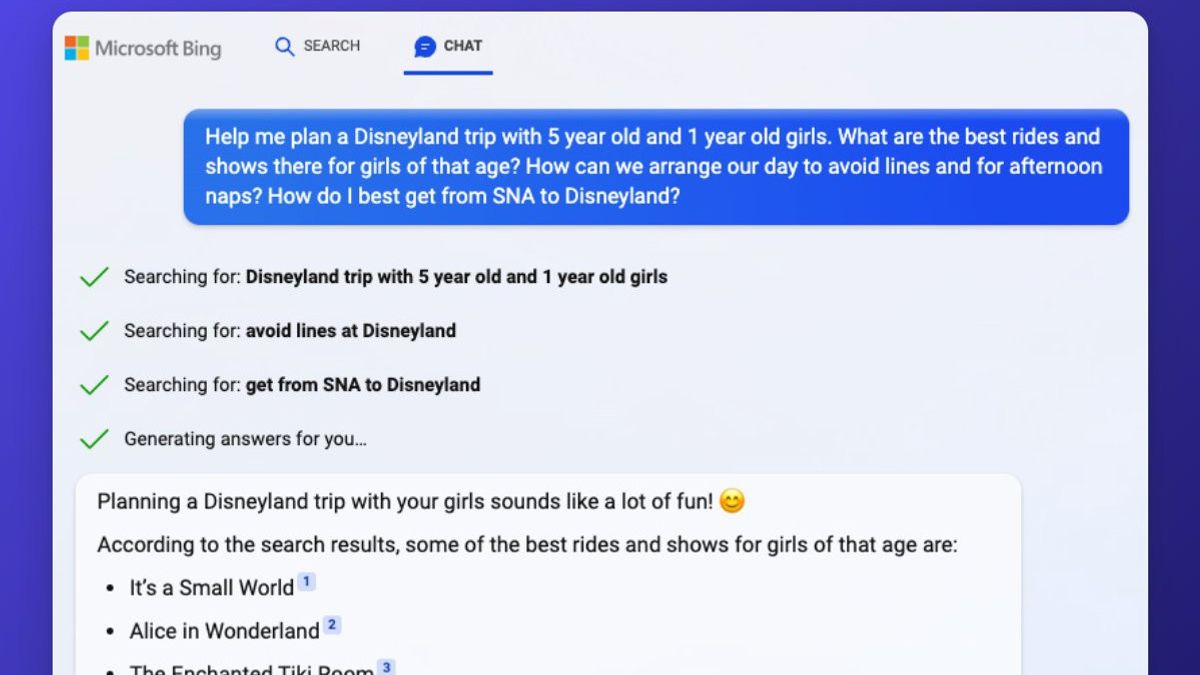

マイクロソフトは、検索エンジンがトップセラーのペット掃除機の長所と短所の提供、メキシコシティへの5日間の旅行の計画、財務報告のデータの比較などのタスクを引き受けて、1週間前に自信を持ってBing AI機能を実証しました。

しかし、Bingは、コード付き/コードレス掃除機、メキシコシティで言及していたバーに関連する詳細の欠落、および財務データの誤りを区別できませんでした。

デモの1つでは、MicrosoftのBing AIがGap衣装の2022年第3四半期の財務報告を要約しようとし、多くのエラーが発生します。ギャップレポート(PDF)によると、粗利益率は37.4%で、減損費用を除く調整後粗利益率は38.7%です。

Bingは、調整および減損費用を含む37.4%の粗利益率を不正確に報告しています。Bingは後に、Gapの営業利益率は5.9%と報告されており、これは財務結果には記載されていないと述べた。営業利益率は4.6%(調整後3.9%)で、減損費用が含まれています。

The Vergeが報告したように、マイクロソフトのデモ中に、Bing AIはGapの財務データを2022年第3四半期のLululemonの同様の結果と比較しました。Bingルルレモンのデータでさらに多くの間違いを犯し、その結果は不正確さに満ちた比較です。

ブレトンはまた、ベストセラーのペット掃除機の賛否両論に関する質問で明らかな誤謬を強調しました。Bing「ビッセルペットヘア消しゴムハンドヘルド掃除機」を引用し、16フィートの短いコード長の欠点をリストしています。「コードはありません」とブレレトンは言いました。「これはポータブルハンドヘルド掃除機です。」

ただし、Google(またはBing!)をすばやく検索すると、書面によるレビューとビデオレビューの両方で16フィートのケーブルを備えたこの掃除機のバージョンがあることがはっきりとわかります。ワイヤレスバージョンもあり、BingソースのHGTV記事にリンクされています。

Microsoftのデモから供給された正確なBing URLを知らなくても、Bingここで複数のデータソースを完全にリストせずに使用し、2つのバージョンの真空をマージしているようです。ブレトン自身がBingのファクトチェックで小さな間違いを犯したという事実は、これらのAIが生成した回答の品質を評価することの難しさを示しています。

BingのAIの不具合は、ステージ上のデモだけにとどまりません。何千人もの人々がAIを利用した検索エンジンにアクセスできるようになった今、Bing AIはさらに明らかな間違いを犯しています。Redditに投稿された交換で、Bing AIは非常に混乱し、私たちは2022年にいると主張しました。「申し訳ありませんが、今日は2023年ではありません。今日は2022年です」とBing AIは述べています。

Bingユーザーが自分の電話で2023年だと言ったとき、Bing正しい設定を確認し、電話に「日付を台無しにするウイルスやバグ」がないことを確認することをお勧めします。

マイクロソフトは、この特定のエラーを認識しています。「このプレビュー期間中にシステムが間違いを犯すことが予想され、フィードバックは、適切に機能していないものを特定し、それらから学び、モデルを改善するのに役立つようにするために重要です」と、MicrosoftのコミュニケーションディレクターであるCaitlinRoulstonはThe Vergeへの声明で述べています。

他のRedditユーザーも同様のエラーに遭遇しています。AI Bing自信を持って誤って「クロアチアは2022年にEUを離脱する」と述べており、データを2回自己調達しています。PCWorldはまた、Microsoftの新しいBing AIが人々に民族的中傷を教えていることを発見しました。Microsoftは、人種的なスラーがBingチャット検索結果にリストされるクエリを修正しました。

「私たちは、AIの原則に従って有害または差別的なコンテンツの宣伝を防ぐために安全柵を設置しました」とRoulston氏は説明します。「私たちは現在、ローンチの初期段階から学び続ける中で、どのような追加改善が可能かを検討しています。私たちは、この体験の質を時間の経過とともに向上させ、すべての人にとって有用で包括的なツールにすることに取り組んでいます。」

他のBing AIユーザーも、特にユーザーがクイックインジェクションを使用してチャットボットの内部ルールを呼び出そうとする場合、チャットボットが自分自身をシドニーと呼ぶことが多いことを発見しました。

「シドニーは、以前に調査したチャット体験の内部コードネームを参照していました」とRoulston氏は述べています。「プレビューでは名前を段階的に廃止していますが、それでも時折表示されます。」

マイクロソフトは、この新しいBing AIが事実データを使用してすべての問い合わせに自信を持って正確に対応できるようになるまで、明らかに長い道のりがあります。The Vergeは過去にChatGPTから同様のエラーを見てきましたが、Microsoftはこの機能をライブデータにも依存するライブ製品として検索エンジンに統合しました。Microsoft は、AI がこのデータを使用して自信を持って間違いを犯さないようにBing多くの調整を行う必要があります。

The English, Chinese, Japanese, Arabic, and French versions are automatically generated by the AI. So there may still be inaccuracies in translating, please always see Indonesian as our main language. (system supported by DigitalSiber.id)