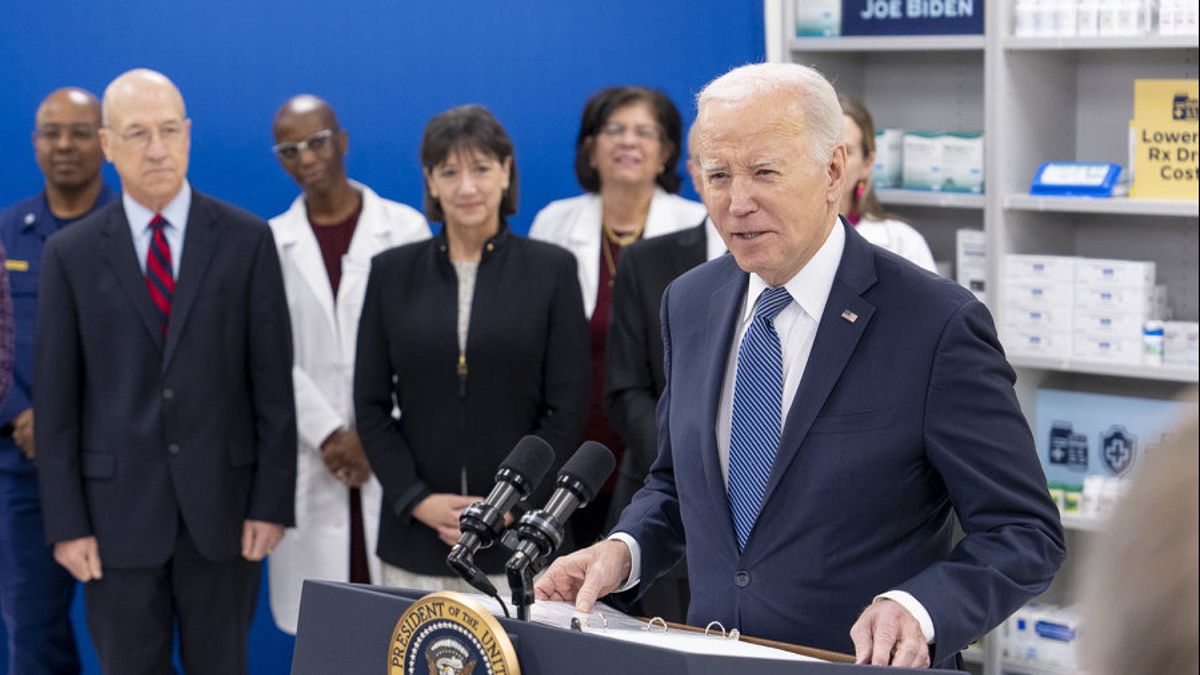

JAKARTA - Mardi 19 décembre, l’administration du président américain Joe Biden a annoncé les premières étapes vers la préparation de normes et de directives clés pour l’utilisation sécurisée de l’intelligence génératrice et la façon de tester et de protéger les systèmes.

L'Institut national des normes et de la technologie du Département du Commerce des États-Unis a déclaré qu'il recherchait une opinion publique jusqu'au 2 février pour effectuer des tests clés essentiels pour assurer la sécurité des systèmes d'intelligence artificielle (IA).

La ministre du Commerce, Gina Raimondo, a déclaré que ces efforts avaient été déclenchés par une ordonnance exécutive du président Joe Biden d’octobre sur l’IA et visait à développer « une norme industrielle basée sur la sécurité, la sécurité et la confiance de l’IA qui permettra aux États-Unis de continuer à diriger le monde dans le développement et l’utilisation responsable de cette technologie en développement rapide ».

Nvist élève des lignes directrices pour évaluer l’IA, faciliter le développement standard et fournir un environnement de test pour évaluer les systèmes d’IA. Cette demande demande demande demande les commentaires des entreprises d’IA et du public concernant la gestion génératrice des risques d’IA et la réduction des risques informatiques générés par l’IA.

L'IA générative - qui peut créer des textes, des photos et des vidéos en réponse à une ordonnance ouverte - a suscité ces derniers mois d'excavation et de peur que cette technologie puisse rendre certains emplois usagés, perturber les élections générales et avoir le potentiel de surmonter les humains avec des conséquences terribles.

L’ordre de Biden a chargé les agences de fixer des normes pour ces tests et de surmonter les risques liés à la chimie, à la biologie, à la radiologie, au nucléaire et à la cybersécurité.

N sina s’efforce de établir des lignes directrices pour le test, y compris où le « équipage rouge » serait très utile pour l’évaluation et la gestion des risques de l’IA et l’établissement des meilleures pratiques pour le faire.

Les équipes rouges exérieures sont utilisées depuis des années dans la cybersécurité pour identifier de nouveaux risques, le terme se référant à une simulation américaine de guerre froide dans laquelle l’ennemi est appelé une « équipe rouge ».

En août, l’événement « en équipe rouge » a eu lieu pour la première fois publiquement aux États-Unis lors de la principale conférence de cybersécurité et a été organisé par AI Village, SeedAI, Human Intelligence.

Des milliers de participants ont tenté de voir s « pouvaient créer un système générer des résultats indésirables ou échouer d’autres manière, dans le but de mieux comprendre les risques auxquels ces systèmes étaient confrontés », a déclaré la Maison Blanche.

L’événement « montre comment le rechange en équipe externe peut être un outil efficace pour identifier les nouveaux risques d’IA », a ajouté le communiqué.

The English, Chinese, Japanese, Arabic, and French versions are automatically generated by the AI. So there may still be inaccuracies in translating, please always see Indonesian as our main language. (system supported by DigitalSiber.id)