جاكرتا - لم يكن روبوت الدردشة الذكاء الاصطناعي من Google هو الوحيد الذي ارتكب خطأ واقعيا خلال عرضه التوضيحي الأول. وجد الباحث المستقل في الذكاء الاصطناعي ديمتري بريريتون أن أول عرض تجريبي ل Bing الذكاء الاصطناعي من Microsoft مليء بأخطاء البيانات المالية.

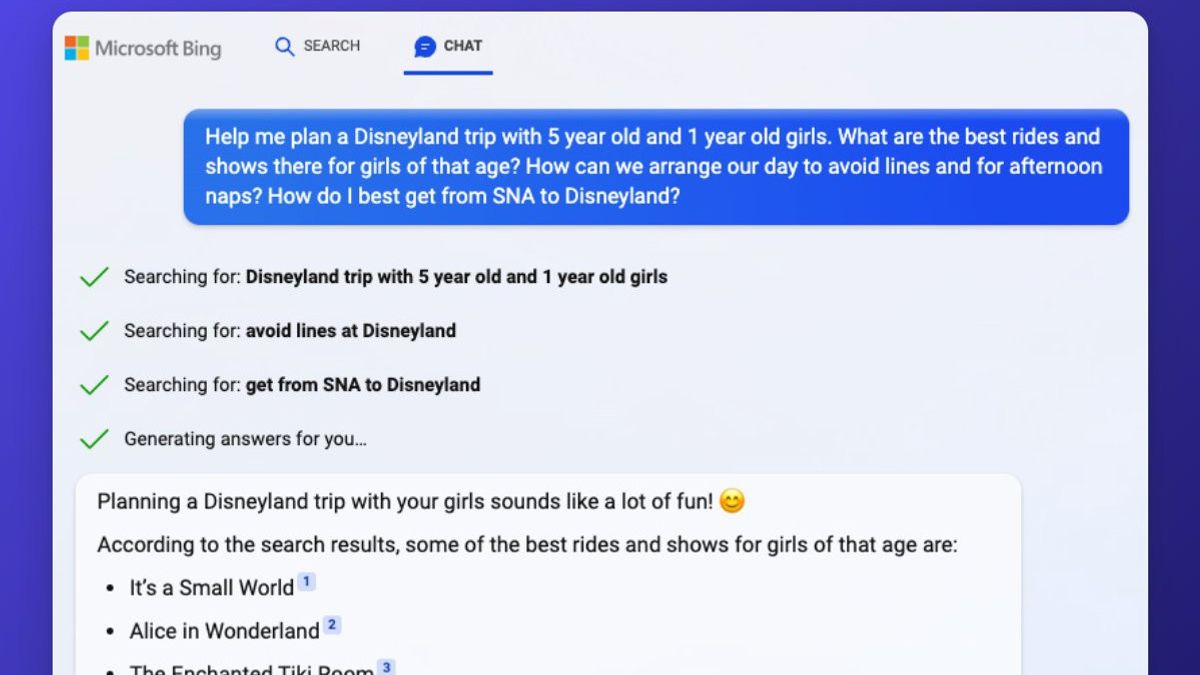

أظهرت Microsoft بثقة قدرات Bing الذكاء الاصطناعي الخاصة بها قبل أسبوع ، حيث تولى محرك البحث مهام مثل توفير إيجابيات وسلبيات مكانس الحيوانات الأليفة الأكثر مبيعا ، والتخطيط لرحلة لمدة 5 أيام إلى مكسيكو سيتي ، ومقارنة البيانات في التقارير المالية.

ومع ذلك ، فشل Bing في التمييز بين الفراغ السلكي / اللاسلكي ، وفقدان التفاصيل ذات الصلة بالشريط الذي كان يشير إليه في مكسيكو سيتي ، والبيانات المالية الخاطئة - إلى حد بعيد أكبر خطأ له.

في أحد العروض التوضيحية ، يحاول Bing الذكاء الاصطناعي من Microsoft تلخيص تقاريره المالية للربع الثالث من عام 2022 لزي Gap ويحصل على الكثير من الأخطاء. ويشير تقرير الفجوة (PDF) إلى أن الهامش الإجمالي يبلغ 37.4 في المائة، مع هامش إجمالي معدل بنسبة 38.7 في المائة باستثناء رسوم انخفاض القيمة.

يبلغ Bing بشكل غير دقيق عن هامش إجمالي بنسبة 37.4 بالمائة بما في ذلك التعديلات ورسوم انخفاض القيمة. وذكر Bing في وقت لاحق أن Gap لديها هامش تشغيل معلن بنسبة 5.9 في المائة ، والذي لم يظهر في النتائج المالية. ويبلغ الهامش التشغيلي 4.6 في المائة، أو 3.9 في المائة معدلة ويشمل رسوم انخفاض القيمة.

كما ذكرت The Verge ، خلال العرض التوضيحي ل Microsoft ، قارن Bing الذكاء الاصطناعي البيانات المالية لشركة Gap بنتائج مماثلة من Lululemon خلال الربع الثالث من عام 2022. ارتكب Bing المزيد من الأخطاء مع بيانات Lululemon ، والنتيجة هي مقارنة مليئة بعدم الدقة.

سلط بريريتون الضوء أيضا على المغالطات الواضحة مع الأسئلة المتعلقة بإيجابيات وسلبيات مكانس الحيوانات الأليفة الأكثر مبيعا. يستشهد Bing ب "مكنسة Bissell Pet Hair Eraser المحمولة" ، ويسرد العيوب بطول سلك قصير يبلغ 16 قدما. قال بريريتون: "لا يوجد حبل". "هذا فراغ محمول باليد."

ومع ذلك ، سيظهر بحث Google السريع (أو Bing!) بوضوح أن هناك نسخة من هذا الفراغ مع كابل بطول 16 قدما في كل من المراجعات المكتوبة والفيديو. هناك أيضا إصدار لاسلكي ، مرتبط في مقالة HGTV من مصادر Bing.

بدون معرفة عنوان URL ل Bing الدقيق الذي تم الحصول عليه من العرض التوضيحي ل Microsoft ، يبدو أن Bing يستخدم مصادر بيانات متعددة هنا دون إدراجها بالكامل ، ودمج نسختي الفراغ. تشير حقيقة أن بريريتون نفسه ارتكب خطأ صغيرا في التحقق من الحقائق على Bing إلى صعوبة تقييم جودة هذه الإجابات التي تم إنشاؤها بواسطة الذكاء الاصطناعي.

لا تقتصر مواطن الخلل الذكاء الاصطناعي في Bing على العروض التوضيحية على خشبة المسرح فقط. الآن بعد أن تمكن الآلاف من الأشخاص من الوصول إلى محرك بحث يعمل بنظام الذكاء الاصطناعي ، يرتكب Bing الذكاء الاصطناعي أخطاء أكثر وضوحا. في تبادل تم نشره على Reddit ، الذكاء الاصطناعي Bing مرتبكا للغاية وجادل بأننا في عام 2022. «آسف، ولكن اليوم ليس 2023. اليوم هو عام 2022»، قال بينغ الذكاء الاصطناعي.

عندما يقول مستخدم Bing إنه عام 2023 على هاتفه ، يقترح Bing التحقق من الإعدادات الصحيحة والتأكد من أن الهاتف لا يحتوي على "فيروس أو خطأ يفسد التاريخ".

Microsoft على علم بهذا الخطأ بالذات. "نتوقع أن يرتكب النظام أخطاء خلال فترة المعاينة هذه ، والتعليقات ضرورية للمساعدة في تحديد الأشياء التي لا تعمل بشكل صحيح حتى نتمكن من التعلم منها ومساعدة النموذج على التحسن" ، قالت كيتلين رولستون ، مديرة الاتصالات في Microsoft ، في بيان ل The Verge.

واجه مستخدمو Reddit الآخرون أخطاء مماثلة. يقول Bing الذكاء الاصطناعي بثقة وبشكل غير صحيح "كرواتيا ستغادر الاتحاد الأوروبي في عام 2022" ، مصادر ذاتية مرتين للبيانات. اكتشف PCWorld أيضا أن الذكاء الاصطناعي Bing الجديد من Microsoft يعلم الناس الإهانات العرقية. قامت Microsoft الآن بإصلاح استعلام يتسبب في إدراج الإهانات العنصرية في نتائج بحث دردشة Bing.

يوضح رولستون: "لقد وضعنا أسوار أمان لمنع الترويج للمحتوى الضار أو التمييزي وفقا لمبادئنا الذكاء الاصطناعي". "نحن نبحث حاليا في التحسينات الإضافية التي يمكننا إجراؤها بينما نواصل التعلم من المراحل الأولى من إطلاقنا. نحن ملتزمون بتحسين جودة هذه التجربة بمرور الوقت وجعلها أداة مفيدة وشاملة للجميع ".

وجد مستخدمو الذكاء الاصطناعي Bing الآخرون أيضا أن chatbot غالبا ما يشير إلى نفسه باسم سيدني ، خاصة عندما يستخدم المستخدمون حقنة سريعة لمحاولة استدعاء القواعد الداخلية لروبوت الدردشة.

قال رولستون: "كانت سيدني تشير إلى اسم رمز داخلي لتجربة الدردشة التي استكشفناها سابقا". "نحن نتخلص تدريجيا من الأسماء في المعاينات ، لكنها لا تزال تظهر من حين لآخر."

من الواضح أن Microsoft أمامها طريق طويل لتقطعه حتى يتمكن الذكاء الاصطناعي Bing الجديد هذا من الرد بثقة ودقة على جميع الاستفسارات ببيانات واقعية. شهدت The Verge أخطاء مماثلة من ChatGPT في الماضي ، لكن Microsoft قامت بدمج هذه الوظيفة مباشرة في محرك البحث الخاص بها كمنتج مباشر يعتمد أيضا على البيانات الحية. تحتاج Microsoft إلى إجراء الكثير من التعديلات لضمان توقف Bing الذكاء الاصطناعي عن ارتكاب الأخطاء بثقة باستخدام هذه البيانات.

The English, Chinese, Japanese, Arabic, and French versions are automatically generated by the AI. So there may still be inaccuracies in translating, please always see Indonesian as our main language. (system supported by DigitalSiber.id)